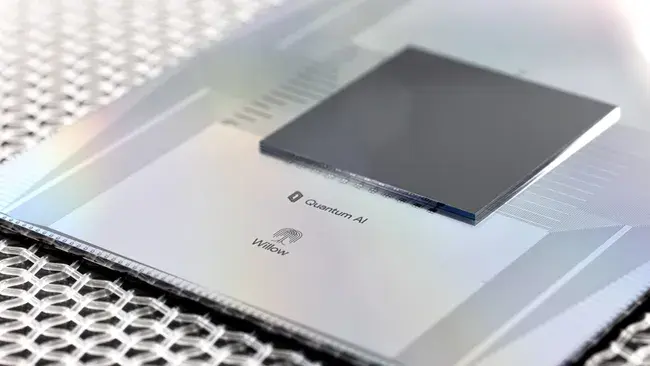

Llega el nuevo procesador cuántico de Google, pero ¿qué implica en realidad?

17 de diciembre de 2024

Google acaba de anunciar un importante avance en tecnología de computación cuántica con el anuncio de su procesador Willow, sucesor del ya revolucionario Sycamore, pero... ¿Cuáles son sus implicaciones?

Como disclaimer, antes de meterme en harina, no es el propósito de este post comentar cómo funciona la computación cuántica —eso requeriría un artículo bastante más largo y además ya los hay mucho mejores de lo que yo pueda escribir—, así que voy a centrarme en lo que, en mi opinión, representa este avance en sí mismo.

Principalmente, Willow, el nuevo procesador cuántico de Google, representa tres grandes logros:

- Un aumento muy significativo del número de qubits físicos (luego explicaré la cursiva),

- Una mejora significativa (en un factor de 5) en los tiempos de coherencia cuántica para el tipo de tecnología utilizada.

- Un hito de enorme relevancia en la mejora de la corrección de errores.

¿Por qué son importantes estos tres factores?

El número de qubits indica, simplificando un poco, el "tamaño" o "complejidad" del problema que el computador cuántico puede resolver. Los volúmenes actuales de qubits son insignificantes para aplicaciones prácticas, pues se estima que para resolver problemas sencillos de simulación de químíca cuántica o de optimización y aprendizaje automático cuántico, tendríamos que disponer de un mínimo de 1.000 a 10.000 qubits lógicos (luego vuelvo a las cursivas), o incluso hasta 1 millón de ellos.

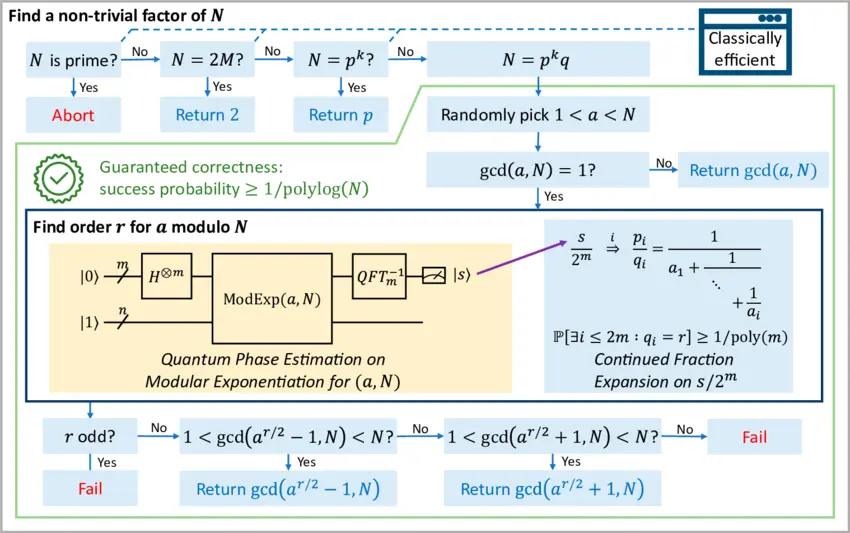

Si queremos meternos en jardines como implementar el algoritmo de Shor para reventar un sistema de cifrado basado en RSA-2048, estaríamos hablando del orden de 20 millones de qubits lógicos.

A formally certified end-to-end implementation of Shor's factorization algorithm - Yuxiang Peng, Kesha Hietala, Runzhou Tao, Xiaodi Wu - ResearchGate

A formally certified end-to-end implementation of Shor's factorization algorithm - Yuxiang Peng, Kesha Hietala, Runzhou Tao, Xiaodi Wu - ResearchGate

¿Qué sucede con ese problema que a un ordenador clásico le llevaría trillones de años resolver y que Willow ha solucionado en solo segundos?

Por no entrar en mucho detalle, se trata de un muestreo de circuitos aleatorios, un tarea diseñada para evaluar la capacidad de los procesadores cuánticos generando distribuciones de probabilidad que son difíciles de emular con computadores clásicos. En realidad, es una mera herramienta para evaluar el rendimiento de los procesadores cuánticos y de paso demostrar su superioridad sobre los clásicos, pero sin aplicación práctica directa en problemas del mundo real.

Es decir, una métrica muy útil para los ingenieros del sector y para los responsables de marketing de las empresas implicadas, pero sin impacto real en la utilidad de estos sistemas para su uso práctico.

¿Y de qué va lo de la corrección de errores?

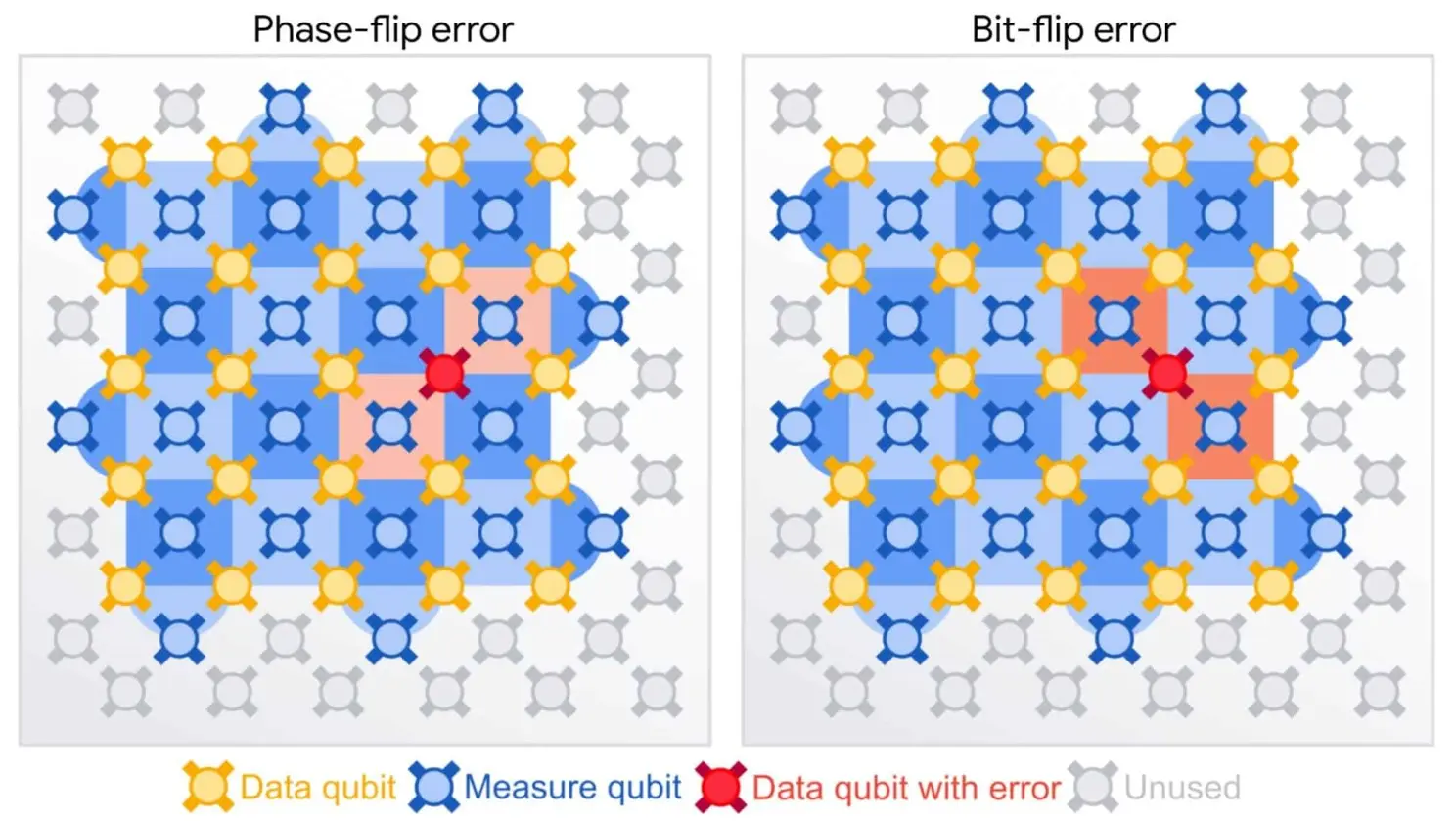

Aquí la cosa es más prometedora: La corrección de errores es otro de los problemas gordos a los que nos enfrentamos con la computación cuántica, pues los qubits físicos son extremadamente sensibles a perturbaciones ambientales, lo que provoca decoherencia (pérdida de su estado cuántico) y otros tipos de ruido.

Para luchar contra esto, se emplean técnicas de corrección de errores, que distribuyen la información cuántica a través de varios qubits físicos. Por eso mis cursivas anteriores: el número de qubits físicos es superior al número de qubits lógicos, pues son necesarios varios de los primeros para disponer de uno de los segundos, y son los segundos los que nos importan para resolver cálculos.

En aproximaciones previas al problema, este enfoque requiere una cantidad considerable de recursos y en muchos casos la tasa de errores no disminuye lo suficiente al incrementar el número de qubits físicos. El avance de Willow está en que demuestra una forma de conseguir una reducción exponencial de los errores al incrementar el número de qubits físicos dedicados a cada qubit lógico, alcanzando un "umbral" que indica que el sistema se vuelve más robusto a medida que aumenta su tamaño (cosa que no ocurría con aproximaciones previas).

Esto permite que los qubits lógicos mantengan su coherencia durante periodos más prolongados y con mayor fiabilidad, algo vital para desarrollar computadoras cuánticas prácticas y escalables. En todo caso, Willow se ha enfrentado a otro límite en este crecimiento exponencial que, desde Google, aseguran que están trabajando en resolver.

Breakthrough in quantum error correction could lead to large-scale quantum computers (Physics World)

Breakthrough in quantum error correction could lead to large-scale quantum computers (Physics World)

¿Y de qué va eso del tiempo de coherencia?

El tiempo de coherencia es importante, porque es el tiempo máximo que tenemos para completar cualquier cálculo antes de que el estado cuántico se degrade y la operación que estamos realizando se volatilice a medias. Y los 100 microsegundos que aguantan los qubits lógicos de Willow son insuficientes para ejecutar algoritmos cuánticos complejos, que pueden requerir miles o millones de puertas cuánticas, cada una con su tiempo de procesamiento, más lento que las operaciones binarias en computadores clásicos.

Para empeorar las cosas, a este tiempo de procesamiento de las puertas hay que añadir el nada desdeñable tiempo de overhead necesario para realizar la corrección de errores, conocido como "sobrecarga de corrección de errores", que aumenta los tiempos globales del cálculo.

¿En qué tiempos de coherencia deberíamos estar entonces para hacer cálculos prácticos? Pues dependiendo del problema, entre milisegundos —1 orden de magnitud por encima del actual— para simulaciones químicas básicas hasta 10 segundos —5 ordenes de magnitud, 100.000 veces más— si queremos ejecutar el algoritmo Shor —sin contar con los millones de qubits físicos necesarios para el mismo—. Vamos avanzando, pero nos queda camino por recorrer.

Vale, pero entonces ¿Qué más cosas resultan interesantes de Willow?

Entre otras, el proceso de fabricación. Si bien para que este procesador funcione seguimos necesitando temperaturas criogénicas —del orden los milikelvin, extremadamente cercanas al cero absoluto—, el proceso de fabricación utiliza tecnologías de semiconductores bien desarrolladas, lo que facilita muchísimo la escalabilidad e hipotéticamente nos permitiría fabricar estos procesadores con tecnologías que ya conocemos y dominamos bastante bien, reduciendo los costes y complejidades asociadas.

![]() How to make supercomputing circuits our of a semiconductor (Tahan Research)

How to make supercomputing circuits our of a semiconductor (Tahan Research)

Otras tecnologías de computación cuántica como las trampas de iones son muchísimo más complejas de fabricar y menos escalables, las velocidades de sus puertas lógicas son significativamente más lentas —lo que anula por lo menos parcialmente la ventaja de su mayor tiempo de coherencia—. Y si hablamos de tecnologías como la fotónica cuántica o de los qubits topológicos en los que Microsoft ha realizado anuncios sonados recientemente, tocamos tecnologías aún menos maduras y mucho menos escalables.

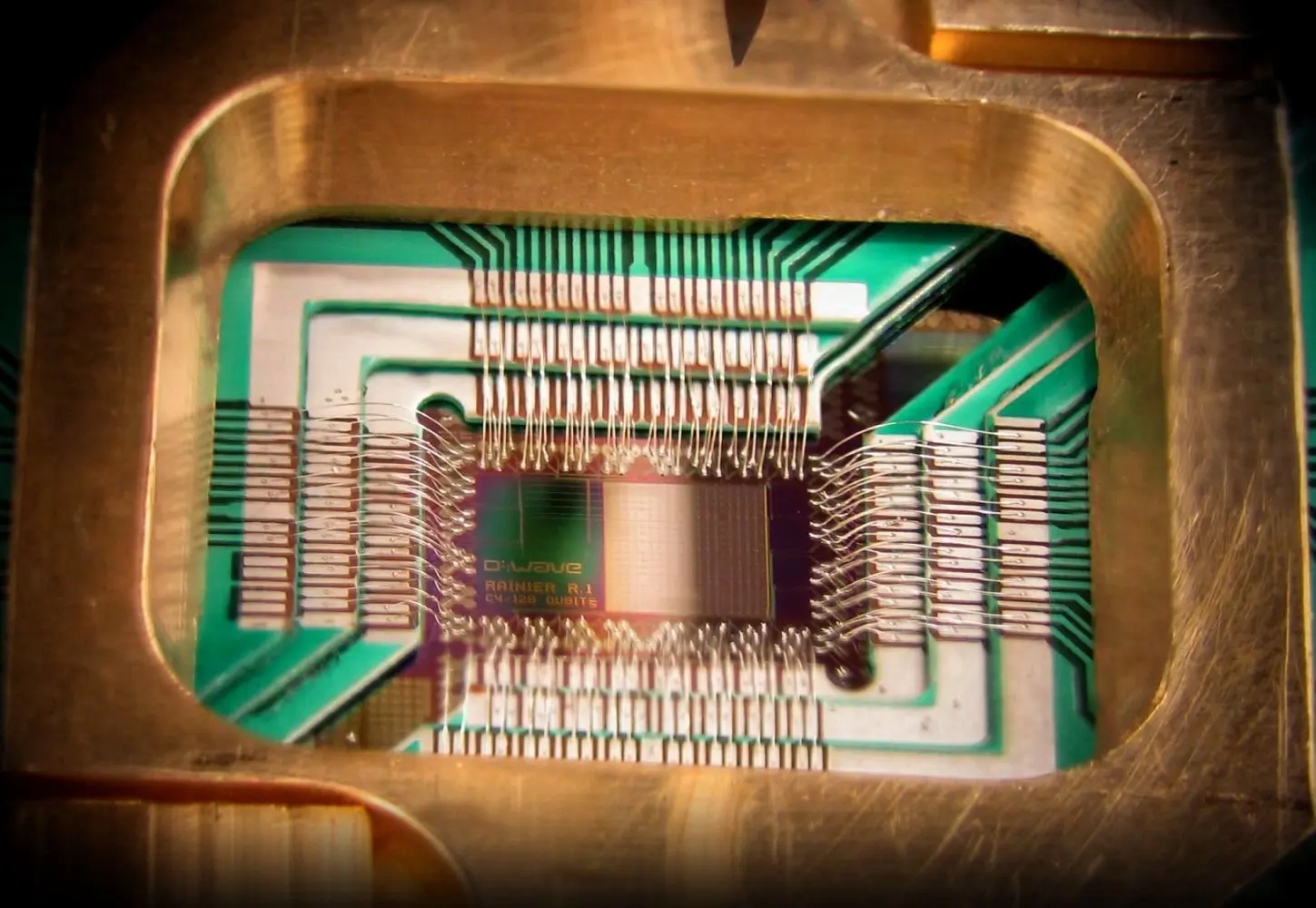

Mención aparte a la tecnología del quantum annealing —o recocido cuántico— empleada por sistemas como los de D-Wave, que si bien tiene ya aplicaciones prácticas, estas son particularmente limitadas a campos como la optimización combinatoria o ajuste de parámetros para machine learning, obteniendo resultados interesantes en planificación logística, diseño de materiales y optimización financiera.

Sin embargo, el quantum annealing tiene el problema de no ser un sistema de computación universal: no puede ejecutar cualquier algoritmo cuántico como el de Shor o el de Grover, y puede no encontrar siempre la solución óptima por su naturaleza heurística, lo que requiere una cierta aproximación "artesanal" —que me perdonen los expertos— al planteamiento de sus soluciones.

D-Wave One Quantum Annealing chip - Wikipedia/D-Wave

D-Wave One Quantum Annealing chip - Wikipedia/D-Wave

¿Entonces la computación cuántica sigue sin ser práctica?

Podemos decir, sin temor a equivocarnos, que a esta tecnología le falta todavía madurar bastante, pero eso no quita que los avances que se han producido hayan dado ya sus frutos, tanto a nivel de la ciencia básica e ingeniería aplicada en su diseño y construcción como en la solución de problemas prácticos como los mencionados en el caso del Quantum Annealing.

Más aún, la matemática involucrada en la exploración de estos sistemas ya nos ha proporcionado nuevas formas de solución de problemas, como los algoritmos quantum inspired desarrollados por nuestro partner Multiverse Computing , con quien trabajamos desde SNGULAR, capaces de resolver problemas clásicos o relacionados con el machine learning en computadores clásicos de manera mucho más rápida o práctica.

En resumen, como en cualquier campo de frontera, cada avance en este campo nos está permitiendo abrir nuevas vías de investigación y conocimiento que expanden nuestra capacidad científica y tecnológica. Pero, lamentablemente, todavía quedan años para poder tener profundas charlas filosóficas con Inteligencias Artificiales basadas en computación cuántica.Lo cual no quita, por supuesto, que este anuncio de Google sea un paso de gigante y ponga a la empresa de Mountain View a la vanguardia de una revolución que promete cambiar el mundo de una forma difícil de concebir hoy en día.

Nuestras últimas novedades

¿Te interesa saber cómo nos adaptamos constantemente a la nueva frontera digital?

Tech Insight

13 de enero de 2025

Cómo acercar tu aplicación a todas las personas

Tech Insight

19 de diciembre de 2024

Contract Testing con Pact - La guía definitiva

Insight

18 de diciembre de 2024

Agilidad, complejidad y método empírico

Insight

10 de diciembre de 2024

Tecnologías rompedoras hoy, que redibujarán el mapa de la innovación en 2025